前回は問2を解説しました。

bananarian.hatenablog.com

前回の記事の感想としては、問2は[1]と[3]さえ乗り切れば大したことない問題かなーとは思いましたが、完答はかなり勉強してる人じゃないとしんどそうですね。

2017年 統計検定1級 統計数理 問3 対策用解説 を始めていきます。

スポンサーリンク

あと、この統計検定カテゴリーですが、少しずつ遡っていって、過去問の解説を全部のっけていけるといいなーと思ってます。

個人的に統計検定について調べていて感じたことなんですが、

特に1級の解答解説については、正確なものがネットに殆ど転がっていないなーと思いました。

(何やら怪しげな計算をしている解答記事は多々ありましたが)

というわけで、解答をボチボチあげてくことも、世間に需要があるんじゃないかなーと思っている次第です。

あ、おかしな証明は書いていないつもりですが、もしツッコミがあれば当然歓迎です。

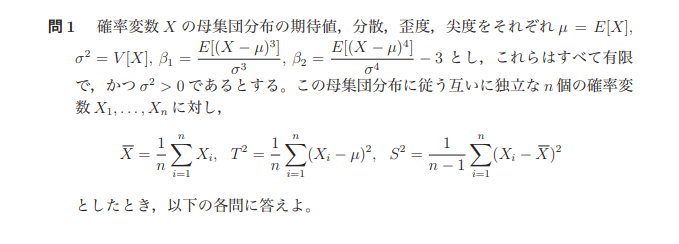

問3の概要

問3のセットアップを見ていきましょう。

標準的なポアソン分布ですね。ポアソン分布は結構色々な性質があって、問題にしやすい分布かなーとは思います。

今回の[1]から[4]も標準な問題が多いですね。

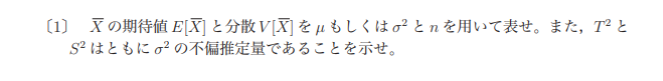

問3[1]

ポアソン分布は二項分布から導出されます。その導出がしっかり出来ますかという問題ですね。

まず、ポアソン分布の密度関数は問題にもある通り次の通り

ちょっと式をいじってみましょう。

では、nを極限に飛ばしてみましょう。

ここで、仮定より、

更に、

であることはすぐわかりますし、の定義から、次のことも分かります。

以上より、

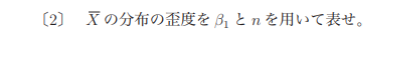

問3[2]

まず、モーメント母関数の定義は次のようになります。

実際に計算していきます。

ここで一旦について考えてみます。これについてマクローリン展開をしてみると

よって

モーメント母関数はtで一回微分して、t=0を入れれば期待値が、二回微分してt=0を入れれば二乗の期待値が出てきます。

よって

問3[3]

分布の畳み込みに関する問題ですね。ポワソン分布には再生性があるので、和をとってもポワソン分布になります。

それを示せという問題です。

,

とおくことにします。

ここでであるので、

以上よりと

の同時分布から

に関する周辺分布を求めればよく、

二項定理より、

このことより、もポアソン分布に従うことが分かりますね。

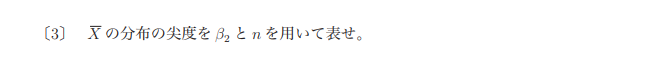

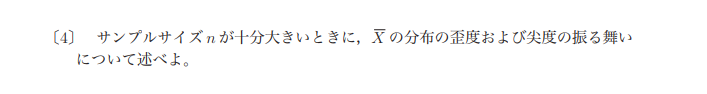

問3[4]

最後ですね。ポワソン分布はにおいて漸近的に正規近似します。

色々と証明方法はありますが

今回はせっかくモーメント母関数を出したので、それを利用してモーメント母関数を対数変換したキュムラント母関数が標準正規分布のキュムラント母関数に収束することを示すことで証明します。

ただ、今回は長くなるので母関数と分布の1対1対応することについては既知のこととして証明することとします。

[2]より

このZのモーメント母関数は

ここでキュムラント母関数は

これについてテイラー展開を施すために次の計算を行っておく。

これを元にテイラー展開を行えば

よってのもとで、キュムラント母関数は

に収束することが分かる。

これは標準正規分布のキュムラント母関数である。

よって母関数と分布の1対1対応の関係からのもとで

の分布は標準正規分布に収束する。

以上でした。内容自体は標準的ですが、制限時間内で解くとなると少し時間がかかりそうですね。

次は問4ですね。

-

-

- キーワード---

-

統計検定1級 解説 数理 統計数理 2017年 解答